hexo 博客 SEO 优化

hexo 博客 SEO 优化

由于我写博客的时间比较长,时间长了之后自然搜索引擎就收录,但如果一开始写博客,想要被搜索引擎主动收录还是需要做 SEO 的

这里记录一下 使用 hexo 如何做 SEO ,有一些主题自带了 SEO 优化建议首先查看自己当前使用的主题是否有这个配置项。

生成 sitemap

1 | npm install hexo-generator-sitemap --save |

然后发布后访问:

https://linkinstars.com/sitemap.xml

https://linkinstars.com/baidusitemap.xml

如果可以正常访问到 xml 文件就可以了

提交 sitemap

百度

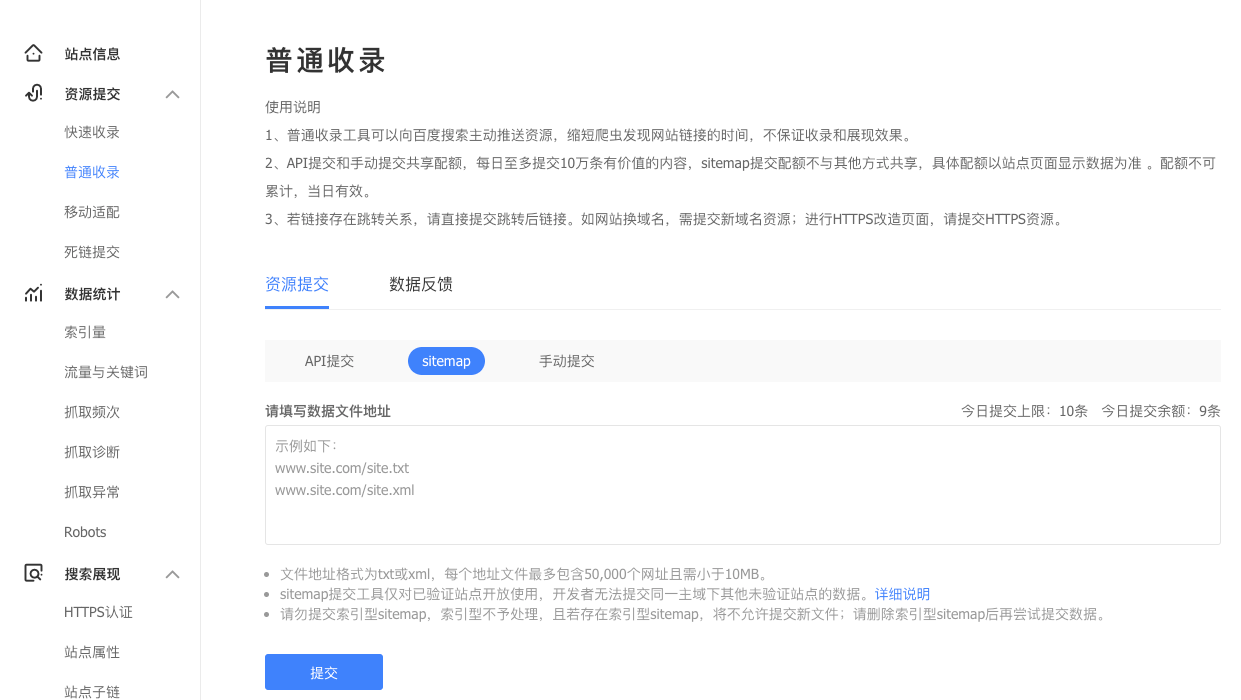

普通收录

登录 https://ziyuan.baidu.com/dailysubmit/index 然后选择自己合适的验证方式验证网站,这一步主要是为了验证当前你想要收录的网站属于你自己。

我这边都采用了 DNS 解析的验证方式,添加一个 CNAME 的解析就好了,非常方便。

然后我这里使用普通收录提交刚才的 sitemap 地址就可以了,大约过一天回来查看。

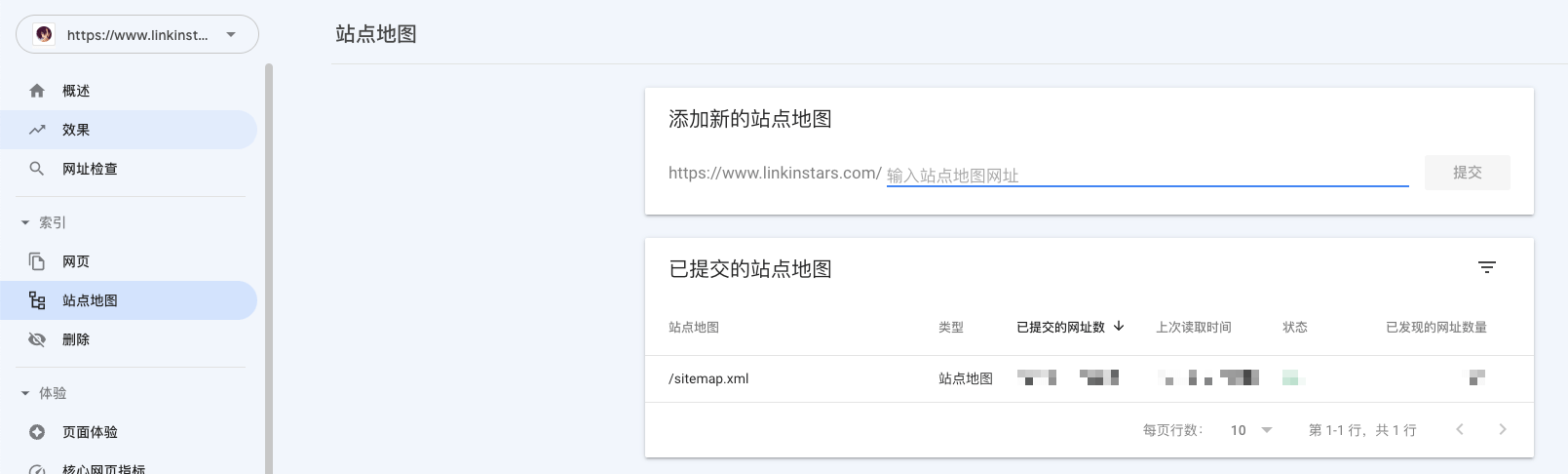

登录 https://search.google.com/search-console (想尽一切办法去登录),也是同样的验证一下网站。

同样的,在站点地图里面添加生成的地址就可以了

bing

必应可以直接同步 google search console 的数据,所以直接登录 https://www.bing.com/webmasters/about 然后选择 google 账户登录并同步一下就好了,非常方便。

如果不想同步,自己重新走一遍类似 google 验证的流程就可以了。

百度主动收录

百度支持你通过 API 进行提交或者手动提交。

安装插件

1 | npm install hexo-baidu-url-submit --save |

修改配置 根目录 _config.yml

添加推送配置,其中 token 在普通收录 API 提交中可以找到

1 | #设置百度主动推送 |

添加部署配置

1 | deploy: |

然后再每次 hexo deploy 部署的时候都会主动推送给百度进行收录。控制台中会打印相关提示信息:类似{"remain":2912,"success":88}

robots.txt

在 hexo 的根目录找到 source 文件夹下,然后创建文件 robots.txt

1 | User-agent: * |

然后在每次使用命令 hexo g 的时候都会在生成的 public 目录中携带 robots.txt 文件,这样就能告诉爬虫什么路径可以爬取,什么路径不能爬取了。

a 标签 nofollow

在出站的 a 标签中添加属性 rel="external nofollow" 我嫌弃麻烦,所以基本都没加

标题优化

我使用的主题 标题 觉得还可以,我不太想加让 title 太长,故没有做修改,如果有需要可以添加 description 或许会好一些,还可以添加关键字 keywords 。由于各个主题的 pug 不同,你需要根据自己的主题去寻找和修改。

参考链接

https://juejin.cn/post/7063450554898317348

https://blog.laoda.de/archives/hexo-baidu-url-submit